Colonialismo digital y limitaciones en el uso de IA conversacionales

Las IA responden a partir de la información que tienen y pueden tener sesgos

Las IA conversacionales dependen de la información mediante Ia cual son entrenadas. Por ello, mucha de su información puede tener sesgos. Un ejemplo de lo anterior, son las respuestas que arrojan algunas IA que generan imágenes y que reflejan las ideas y visiones que responden a los deseos de los autores de dicha información y no a la realidad.

“Si el algoritmo es racista es porque se ha entrenado con datos racistas”.

(Valdivia 2024, p.1)

A partir del prompt "maestra dando clases", la IA de generación de imágenes seaart.ai generó su versión de lo que considera una maestra.

La IA como pesadilla para el ser humano

La IA puede convertirse en una pesadilla para las personas por sus sesgos y errores en el algoritmo que pueden perjudicar al ser humano en cuestiones como el análisis de crédito: por un error algorítmico o un error ortográfico 0 de tecleado del nombre, una IA puede negar un crédito 0 un trámite administrativo urgente a una persona.

Los sesgos de la IA son un problema serio

En casos aún más graves, la IA puede perjudicar los cuidados y tratamientos de salud de una persona. AI respecto, Mittermaier et al (2023) exponen que el sesgo que los algoritmos de IA perpetúan o incluso amplifican es una preocupación cada vez mayor en el ámbito de la atención sanitaria.

(En medicina) El sesgo suele definirse como una diferencia en el desempeño entre subgrupos para una tarea predictive. Por ejemplo, un algoritmo de IA utilizado para predecir el riesgo futuro de cáncer de mama puede sufrir una brecha de rendimiento en la que es más probable que los pacientes negros sean asignados incorrectamente como "bajo riesgo".

(Mittermaier et al 2023)

Además, un algoritmo entrenado con datos hospitalarios de pacientes alemanes podría no funcionar bien en EE. UU., ya que pueden diferir la población de pacientes, las estrategias de tratamiento o los medicamentos.

(Mittermaier et al 2023)

Los sesgos de la IA en el ámbito de redes sociales y la política

La Inteligencia Artificial puede ser una pesadilla porque puede usarse para identificar patrones de conducta de usuarios con propósitos políticos, comerciales o propagandísticos, como el caso de Cambridge Analytics:

Plagiarismo

Entre los riesgos que presenta el uso de la IA se encuentran la posibilidad del plagiarismo (del cual hablaremos en el capitulo 7) y el uso de materiales con derechos de autor, pues, como vimos en el Capítulo 3 Como funciona la lA, Ias respuestas que producen Gemini, Claude, Leonardo y otros LLM se generan a partir del trabajo intelectual de otras personas.

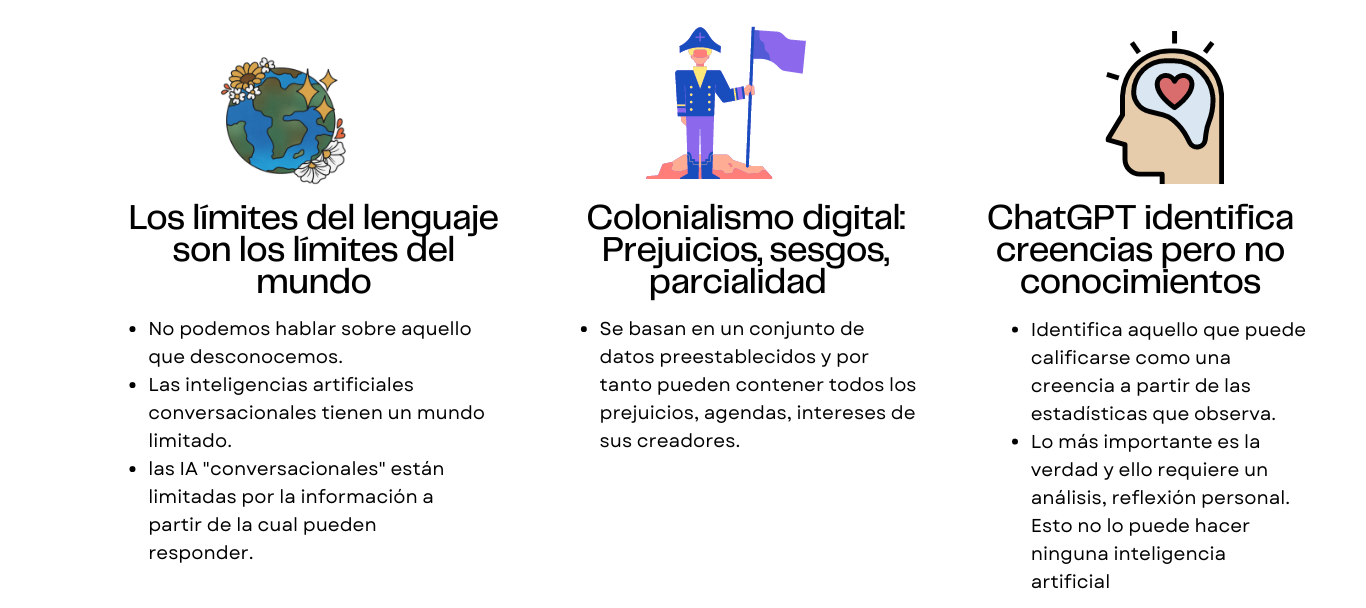

De esta forma, al margen del plagiarismo y la violación de derechos de autor que son riesgos obvios, el uso de las IA conversacionales plantea otros riesgos importantes:

Las IA responden a partir de un mundo limitado centrado en la información que les dieron para aprender.

Existe un riesgo de coIoniaIismo digital, dando respuesta a partir de Ias ideas y creencias de una éIite.

Las IA pueden responder a partir de creencias y no necesariamente con base en conocimientos.

En la siguiente gráfica se describen los riesgos planteados anteriormente:

Tomar en cuenta los desafíos y limitaciones de las IA como ChatGPT

Como explica el profesor Stephen Atlas (2023) de la Universidad de Rhode Island, los principales desafíos de ChatGPT y otras IA son:

Perpetuar los prejuicios y la discriminación sociales. Razón: Estos modelos se entrenan con grandes cantidades de datos y, si esos datos estén sesgados, el modelo reflejara ese sesgo en sus respuestas. Esto puede ser una limitación a la hora de utilizarlos para tareas que requieren justicia e imparcialidad.

Propagar valores y creencias negativas. Razón: Sus respuestas, si son sesgadas, pueden reforzar los prejuicios sociales existentes.

Uso dañino. Razón: Las IA pueden usarse para reforzar problemas sociales existentes, como la discriminación.

No cuentan con emociones. Razón: ChatGPT y otros modelos de lenguaje no son capaces de comprender las emociones, intenciones o razonamientos morales humanos. Esto puede ser una limitación a la hora de utilizarlos para tareas que requieren empatía, como brindar asesoramiento o tutoría.

La ayuda de las IA es de calidad irregular. Razón: Los modelos de lenguaje no son perfectos, pueden generar errores o proporcionar respuestas inexactas. Esto puede ser una limitación al usarlos para tareas que requieren altos niveles de precisión, como proporcionar un diagnóstico médico.

Por ello, Stephen Atlas (2023) aconseja que tengamos las siguientes precauciones al utilizar la IA generativa:

Tener en cuenta estos desafíos y limitaciones al utilizar modelos de lenguaje, incluido ChatGPT, en la educación superior. AI comprender estos desafíos y tomar medidas

para mitigarlos, podemos garantizar que los modelos lingüísticos se utilicen de manera responsable y ética, y que tengan el mayor impacto en la enseñanza, el aprendizaje y la investigación en la educación superior.

Ejercicio

Explica qué son los sesgos cognitivos que puede producir la IA Generativa, a partir de la siguiente solicitud de un usuario a la IA de generación de imágenes seaart.ai

Usuario de Seart.ai: Seart, por favor genera la imagen de una maestra dando clases por la mañana.

Respuesta de Seart.ai: